ඡායාරූපකරණ තාක්ෂණයේ ආරම්භයත් එක්ක වැඩි කලක් නොයා ම නීතිය ඉදිරියේ දීත්, සමාජය ඉදිරියේ දීත් යමක් සිදු වූ බවට සාක්ෂ්යයක් ලෙස ඡායාරූපයක් සලකන්න ප්රවණතාවක් ඇති වුණා. කොහොම වුණත් වංචනික ව විවිධ පුද්ගලයන්ට වෙනත් මුහුණු බද්ධ කරමින් මෙය උඩු යටිකුරු කරවන්න වැඩි කාලයක් ගියේ නැහැ. නමුත් වීඩියෝ සාක්ෂ්යයක් ඉතා මෑතක් වන තුරු සත්ය ලෙස පිළිගැනීමේ නැඹුරුවක් තිබුණා.

කොහොම නමුත් මෑත කාලයේ දී deepfake හෙවත් AI තාක්ෂණය යොදාගෙන වීඩියෝවලට මුහුණු බද්ධ කිරීමත් එක්ක ඒ ගැනත් යම් අවිනිශ්චිත බවක් ඇති වී තිබෙනවා. මේවායේ මුල් කාලීන වීඩියෝ වුවත් ඉතා පහසුවෙන් ව්යාජ බව හඳුනාගන්න ලැබුණත්, වසරක් ගත වෙන්නටත් පෙර බොහෝ දෙනෙකුට හඳුනාගත නොහැකි තරම් සාර්ථක ව ඒවා සංස්කරණය කරන්න හැකි බවට සාක්ෂ්ය පිටතට එන්න පටන් අරන්.

මේ නිසා deepfake වීඩියෝ පැමිණි මුල් සමයේ බොහෝ දෙනෙක් බිය වූ දේවල් දැන් සැබෑවක් වෙන්න පටන් අරන්.

වෙන කෙනෙකුගේ මුහුණක් වීඩියෝවකට බද්ධ කිරීමේ ගැටලු

යම් පුද්ගලයෙකුගේ ඡායාරූපයකට වෙනත් මුහුණක් බද්ධ කිරීම ග්රැෆික් නිර්මාණය පිළිබඳ මූලික දැනුමක් ඇති කෙනෙකුට වුණත් කරන්න පුළුවන්. දක්ෂතාව සහ අදාළ රූප දෙකේ ලක්ෂණ අනුව මෙය බොහෝ දුරට ඇත්තම ඡායාරූපයක් ලෙස සකසන්න බැරි කමක් නැහැ.

කොහොම වුණත් වීඩියෝවක දී පුද්ගලයෙකුගේ මුහුණේ ඉරියව්වල සිදුවන වෙනස්කම්, ආලෝකකරණයේ වෙනස්කම්, හිසකෙස් හෝ රැවුල වැනි දේවල් එහා මෙහා වීම ආදී තත්ත්ව බොහොමයක් ගැන සැලකිලිමත් වීම අවශ්ය යි. මේ නිසා සාමාන්යයෙන් තත්පරයකට රූප රාමු 24 සිට 60 දක්වා ප්රමාණයක් තිබෙන වීඩියෝවක තත්ත්පර කිහිපයක් වුවත් මේ විදිහට එකෙන් එක සකසන්න උත්සාහ කළොත් සමහර විට දින ගණන්, සති ගණන් ඒ වෙනුවෙන්ම කැප වෙන්න වගේ ම අධික මුදලක් ශිල්පීන් වෙනුවෙන් වැය කරන්නත් අවශ්ය යි. මේ නිසා මෙතෙක් එවැනි දේ සිදු කෙරුණේ අධික මිලක් වැය කර නිර්මාණය කරන චිත්රපට ආදිය සඳහා පමණයි.

AI තාක්ෂණයෙන් සියල්ල පහසු කළ deepfake

Deepfakeවල දී සිදු කෙරෙන්නේ මෙය AI හෙවත් කෘත්රීම බුද්ධිය සහ Machine Learning හෙවත් යාන්ත්රික ඉගෙනුම කියන තාක්ෂණයන් යොදාගැනීම යි. දැනටමත් බොහෝ දුරට කෙනෙකුගේ මුහුණේ කොටස් හඳුනාගැනීම දියුණු වී ඇති නිසා (Snapchat/Instagram ආදියේ විවිධ විසුළු රූ මුහුණට සජීවීව එකතු කළ හැකි වීම හොඳ උදාහරණයක්) යම් පුද්ගලයෙකුගේ වීඩියෝ හෝ ඡායාරූප විශාල ප්රමාණයක් තිබෙනවා නම් ඔහුගේ හෝ ඇයගේ මුහුණෙන් පෙන්වන බොහෝ ඉරියව් ඉගෙන ගන්නට පරිගණක වැඩසටහනකට හැකියාව තිබෙනවා.

මෙය ප්රමාණවත් තරම් සිදුකළ පසු ව වෙනත් වීඩියෝවක සිටින පුද්ගලයෙකුගේ මුහුණේ ඉරියව්වලට සමාන ව දැනට ඉගෙන ගත් පුද්ගලයාගේ ඉරියව් නිමානය කරන එක සිදුකරන්න හැකියාව ලැබෙනවා. deepfake වීඩියෝවක සිදුවන්නේ අදාළ වීඩියෝවේ රූප රාමුවෙන් රාමුවට මේ කටයුත්ත සිදුකොට ඒවා ඇසුරෙන් නව වීඩියෝවක් සැකසීම යි.

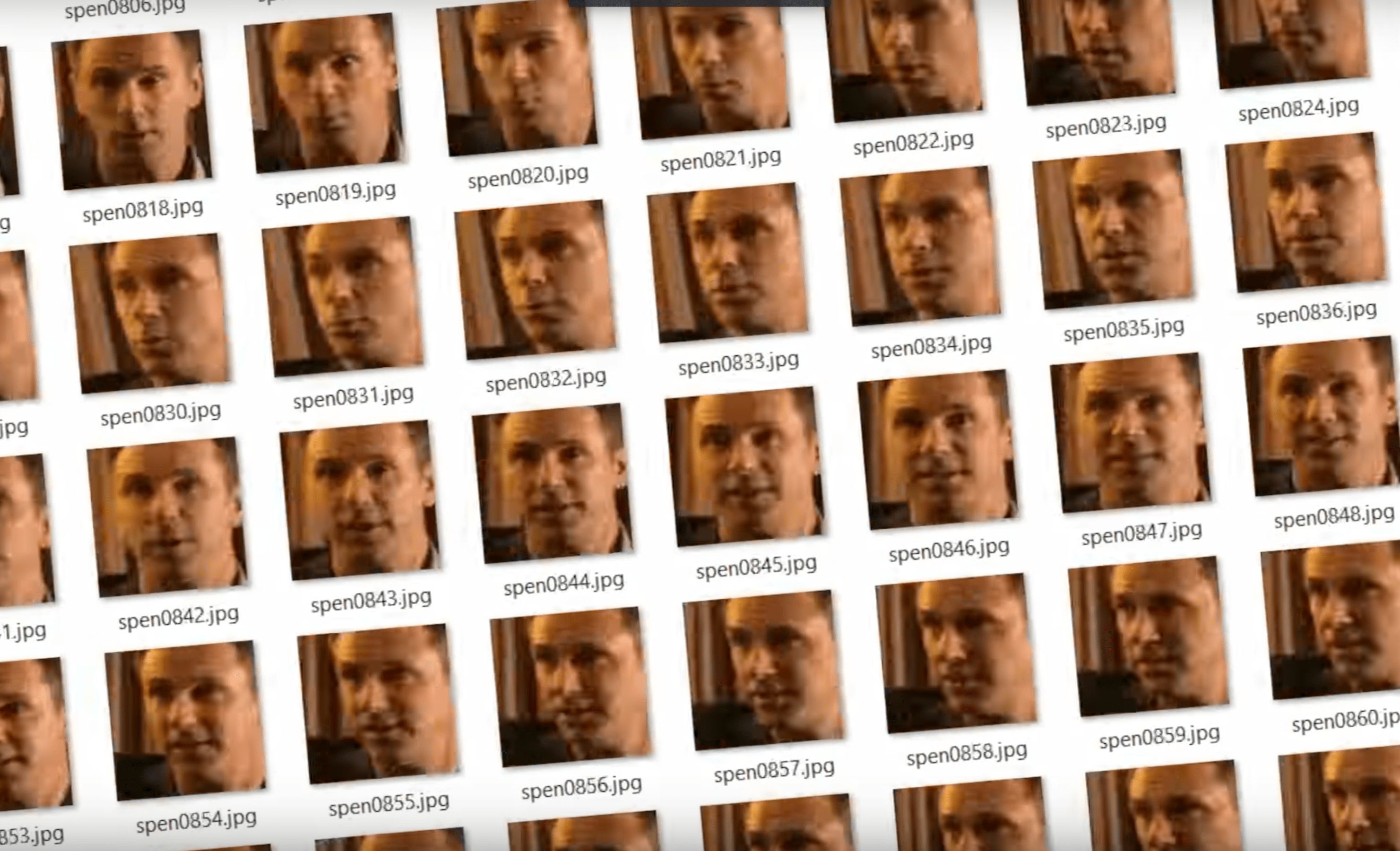

කෙනෙකුගේ විවිධ ඉරියව් සහිත ඡායාරූප විශාල ප්රමාණයක් සොයාගත හැකි නම් මෙය සත්ය තත්ත්වයට ඉතා ම ආසන්න ලෙස සිදුකරන්න පුළුවන්. බොහෝ දෙනෙක් හොඳින් හඳුනන ජනප්රිය පුද්ගලයන්ට මෙය විශාල ගැටලුවක්. දැන් පවතින deepfake වැඩසටහන්වලට ස්වයංක්රීය ව සෙවුම් යන්ත්ර භාවිත කර ඡායාරූප සොයාගන්නට පවා හැකියාව තිබෙනවා. මේ නිසා විශේෂයෙන් ම නළු නිළියන්, දේශපාලන නායකයන් වැනි පුද්ගලයන්ගේ මුහුණ සහිත ව්යාජ වීඩියෝ සත්ය තත්ත්වයට ඉතා ම ආසන්න ලෙස සකස් වීමේ අවදානම ඉතා ඉහළ යි.

හිතුවාට වඩා දියුණු වීම අතිශයින් වේගවත්

deepfake වීඩියෝ මුල්වරට පැමිණි 2017 වර්ෂයේ වැඩි දෙනෙක්ගේ අවධානය යොමු වුණේ හිටපු ඇමෙරිකානු ජනාධිපති බැරක් ඔබාමාගේ සහ හොලිවුඩ් නළු නිකොලස් කේජ්ගේ මුහුණ විවිධ චිත්රපට දර්ශන සහ සාකච්ඡා වැඩසටහන්වලට ඇතුලත් කිරීම වැනි වීඩියෝවලට යි. ඒ කාලයේ ම අතිශයින් ජනප්රිය වූ වොන්ඩ(ර්) වුමන් චිත්රපටයේ ප්රධාන නිළි ගල් ගඩෝට්ගේ මුහුණ සහිත අසභ්ය වීඩියෝවකුත් කරළියට ආවා. කොහොම නමුත් මේවා අදාළ තාක්ෂණය නිරූපණය කිරීමකින් එහාට ගිහින් කෙනෙකු දුටු විගස සත්යයක්යැ යි සිතන මට්ටමක තිබුණේ නැහැ.

ඒත් පසුකාලීන ව ඕනෑම කෙනෙකුට භාවිත කළ හැකි deepfake පරිගණක වැඩසටහනකුත් නිකුත් වීමත් එක්ක ජනප්රිය පුද්ගලයන්ගේ මුහුණු සහිත අසභ්ය වීඩියෝ විශාල ලෙස නිර්මාණය වෙන්න පටන් ගත්තා. මෙවන් වීඩියෝ බොහොමයක් දුටු විගස ව්යාජ බව හඳුනාගත හැකි වුවත් ඉන් ඇතැම් ඒවා ඉතා ම පරීක්ෂාවෙන් බලන තුරු හඳුනාගත නොහැකි මට්ටමට ම දියුණු වී තිබෙනවා.

වසරක් ගත වෙන්නටත් පෙර deepfake වීඩියෝ මෙතරම් දියුණු මට්ටමකට පැමිණීම නිසා ඉතා ම මෑත කාලයේ දී එය සැබෑ ලෙස ම පෙනෙන ව්යාජ වීඩියෝ ගොඩනංවන්න යොදා ගත හැකි වේවි කියන බිය අලුත් වී තිබෙනවා.

ඇති විය හැකි ගැටලු

පැහැදිලි ව ම ජනප්රිය පුද්ගලයන් මෙහි මූලික ම ඉලක්කය යි. විශේෂයෙන් ම බොහෝ දෙනෙක්ගේ ආකර්ෂණය හිමි හොලිවුඩ් සහ බොලිවුඩ් නිළියන්ට මෙය විශාල තර්ජනයක් වන්නට ඉඩ තිබෙනවා. දැනටමත් ඔවුන් බොහෝ දෙනෙකුගේ මුහුණු යෙදූ, සැබෑ තත්ත්වයට ආසන්න ලෙස පෙනෙන අසභ්ය වීඩියෝ ගණනාවක් නිර්මාණය වී තිබෙනවා. අදාළ පුද්ගලයන්ගේ පෞද්ගලිකත්වයටත්, ගෞරවයටත් මෙය විශාල හානියක් විය හැකියි.

කොහොම වුණත් ඊට එහා ගොස් පැතිරුණු විශාල බලපෑමක් ඇති කළ හැකි වීඩියෝ සකස් වීමේ ඉඩකඩ ගැන විශාල බියක් ඇති වී තිබෙනවා. ප්රබල දේශපාලන නායකයෙක්ගේ ව්යාජ ප්රකාශයක වීඩියෝවක් නිකුත් වීම ඉන් ප්රධාන යි. උදාහරණයක් ලෙස ඇමෙරිකානු ජනාධිපතිවරයා වෙනත් රටකට එරෙහිව යුධ ප්රකාශ කිරීමක් වැනි වීඩියෝවක් ගැන සිතන්න. එය නිසා යුද්ධයක් ඇති වීම උහගට වුවත්, ඩොලර් ට්රිලියන ගණනක පිරිවැටුමක් ඇති ඇමෙරිකානු කොටස් වෙළඳපොළ තුළ ක්ෂණික පහළ යාමක් සිදුවෙන්න මෙවැන්නක් ප්රමාණවත්. එවැනි අවස්ථාවක කොටස් මිලට ගෙන යමෙකුට විශාල ආර්ථික ලාභයක් ලබන්න හැකියාව තිබෙනවා.

එවැනි කාරණා නිසා මේ deepfake වීඩියෝ මුදල් උපයන උල්පතක් කරගන්නත් බොහෝ දෙනෙක් මග බලනවා විය හැකියි. මුදල් ඉපයීමේ මාර්ගයක් වීම ලොව ඕනෑම දෙයක් ක්ෂණයකින් පතුරුවාලන්න සමත් වීම නිසා මෙය විශාල ගැටලුවක් විය හැකි බව යි විශේෂඥයන් වැඩි දෙනෙකුගේ අදහස.

Deepfakeවලට එරෙහි පියවර

මේ තත්ත්වය නිසා ම දැනටමත් deepfakeවලට එරෙහිව බොහෝ තාක්ෂණික ආයතන පියවර ගෙන තිබෙනවා. මුහුණ වෙනස් කළ අසභ්ය වීඩියෝවක් දැමීම සාමාන්යයෙන් අසභ්ය වීඩියෝවලට සීමා නොපනවන Twitter ජාලය තුළ වාරණයට ලක් වෙන්න හේතුවක් විය හැකියි. එසේ ම ලොව ප්රධානතම කාමුක වීඩියෝ වෙබ් අඩවියක් වන Pornhub ආයතනයත් එවැනි වීඩියෝ වාර්තා වූ සැණින් ඉවත් කරන්නට ප්රතිඥා දී තිබෙනවා.

නමුත් දිනපතා එකතු වන සුවිසල් වීඩියෝ ප්රමාණයත් සමග එය ප්රායෝගික ව අතිසාර්ථක නැති බව යි කියවෙන්නේ. deepfake වීඩියෝ සකසන පිරිස්වලට එරෙහිව නීතිමය පියවර ගැනීමේ ද උත්සාහයක් පවතිනවා. තමන් දකින වීඩියෝ සැබෑ ද යන්න වඩාත් විචාරශීලී ව බලන්නටත්, ව්යාජ වීමට ඉඩක් ඇති වීඩියෝ සඳහා ඒ බව පරිශීලකයාට දන්වන පණිවිඩයක් පෙන්වීම ඇතුළු වෙනත් පියවරත් අත්හදා බැලෙමින් පවතිනවා.

මේ තරගයෙන් කවුරුන් ජය ගනීවි ද කියා කියන්න තව ම කල් වැඩි යි. කෙසේ වුවත් නියාමනයක් නැති ව AI තාක්ෂණය භාවිතයේ අනිසි ප්රතිඵලවලට deepfake වීඩියෝ තවත් හොඳ උදාහරණයක් බවට නම් කිසිදු සැකයක් නැහැ.