কথ্য ভাষা ছাড়াও আমরা আমাদের আবেগ, অনুভূতি নানানভাবে প্রকাশ করি। চেহারায় ফুটে উঠা অভিব্যক্তি, অঙ্গভঙ্গি, শরীরের নড়াচড়া এবং কণ্ঠস্বরের ওঠানামা দেখে আমরা সহজেই ভীত, আতঙ্কিত, রেগে থাকা মানুষকে চিহ্নিত করতে পারি। কেউ মুখে না বললেও, চেহারা দেখে আমরা বলে দিতে পারি মানুষটি আনন্দে আছে, নাকি দুঃখে, সন্তুষ্ট, নাকি অসন্তুষ্ট। আরো ভালোভাবে খেয়াল করলে কেউ সত্য বলছে, নাকি মিথ্যা, তা-ও চিহ্নিত করা যায়। কিন্তু কেমন হবে যদি মেশিনও এই আবেগ অনুভূতিগুলো চিহ্নিত করতে পারে? ক্যামেরার সাহায্যে মানুষের চেহারা দেখে কোনো সিদ্ধান্তে পৌঁছোতে পারে? অথবা মানুষের আবেগ-অনুভূতি অনুকরণ করতে পারে?

মেশিনের এই আবেগ-অনুভূতি বোঝার এবং সেগুলোকে বিবেচনায় এনে প্রতিক্রিয়া করার ক্ষমতার উপর ভিত্তি করেই গড়ে উঠেছে আর্টিফিশিয়াল ইমোশনাল ইন্টেলিজেন্স বা ইমোশন এআই।

আর্টিফিশিয়াল ইমোশনাল ইন্টেলিজেন্স

আর্টিফিশিয়াল ইন্টেলিজেন্সের এই শাখাটি ১৯৯৫ সালে প্রকাশিত রোজালিন পিকার্ডের গবেষণা পেপারে ‘এফেক্টিভ কম্পিউটিং’ নামে সর্বপ্রথম উঠে আসে। যেখানে বলা হয়, এফেক্টিভ কম্পিউটিং কগনিটিভ কম্পিউটিং এবং আর্টিফিশিয়াল ইন্টেলিজেন্সের এমন একটি শাখা, যেখানে মেশিন মানুষের মাঝে ফুটে ওঠা অভিব্যক্তি, অঙ্গভঙ্গি, কণ্ঠস্বরের ওঠানামাগুলোকে সনাক্ত করার পাশাপাশি সেগুলোকে নির্দিষ্ট একটি ইমোশন হিসেবে সনাক্ত করে অনুকরণ করতে পারবে। প্রয়োজনে সেই সব ইমোশনগুলোর উপর ভিত্তি করে প্রতিক্রিয়া করা, কোনো সিদ্ধান্তে পৌঁছানোর ক্ষমতাও মেশিনের থাকবে।

অর্থাৎ, আমরা এখন যেমন মেশিনকে বুঝতে পারি, অদূর ভবিষ্যতে মেশিনও মানুষকে বুঝতে পারবে। আর এই বুঝতে পারাটা হবে ইমোশনাল স্টেট বা আবেগী অবস্থায়।

ফেশিয়াল অ্যাকশন কোডিং সিস্টেম

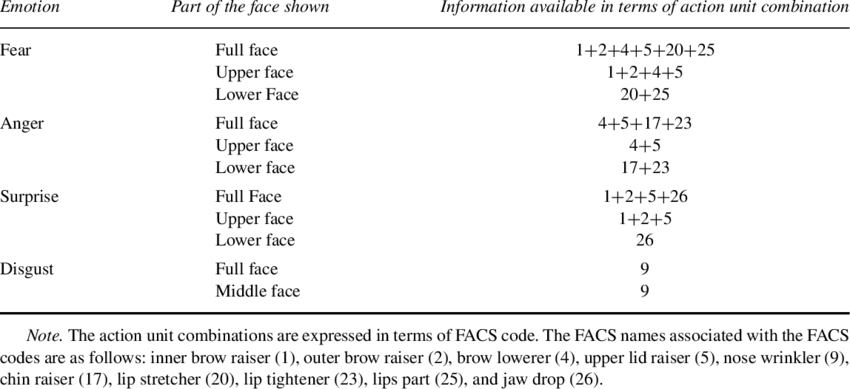

১৯৭২ সালে বিজ্ঞানী পল ইকম্যান আনন্দ, দুঃখ, ভয়, রাগ, বিস্ময়, বিরক্তিকে মানুষের মৌলিক আবেগ হিসেবে চিহ্নিত করেন। যেহেতু মানুষের মুখের অভিব্যক্তি তার ইমোশনাল স্টেট বা আবেগী অবস্থার বহিঃপ্রকাশ করে এবং সেগুলো খুব সহজেই মুখের মাংসপেশির সঙ্কোচন ও প্রসারণ দেখে চিহ্নিত করা যায়। সেহেতু ১৯৭৮ সালে তিনি এবং তার সহকারী বিজ্ঞানী ভি. ফ্রিসেন মিলে মুখের মাংসপেশির সঙ্কোচন-প্রসারণগুলোকে একটি সিস্টেমের আওতায় আনেন, যা ‘ফেশিয়াল অ্যাকশন কোডিং সিস্টেম’ নামে পরিচিত।

সিস্টেমটি মুখের মাংসপেশির সঙ্কোচন এবং প্রসারণগুলোকে নির্দিষ্ট কিছু অ্যাকশন ইউনিটে প্রকাশ করে। সেখানে প্রত্যেকটি মৌলিক আবেগের জন্য আলাদা আলাদা অ্যাকশন ইউনিট কোড রয়েছে। যেমন: আনন্দের জন্য অ্যাকশন ইউনিট কোড ৬+১২, বিস্ময়ের জন্য ১+২+৫বি+২৬।

পরবর্তীতে পল ইকম্যান মাইক্রো-ইমোশনগুলোকে ইউনিট কোডের আওতায় আনতে কাজ শুরু করেন। ফলাফল হিসেবে ১৯৯০ সালে ফেশিয়াল অ্যাকশন কোডিং সিস্টেমের মাধ্যমে আরো এগারোটি মৌলিক আবেগ চিহ্নিত করতে সচেষ্ট হয়। এর মধ্যে আত্মতৃপ্তি, লজ্জা, ঘৃণার মতো পরিচিত আবেগগুলো রয়েছে।

যেভাবে মেশিন মানুষের অনুভূতি বোঝতে পারে

ফেশিয়াল অ্যাকশন কোডিং সিস্টেমটি মূলত চেহারার মাংসপেশির নড়াচড়ার মাধ্যমে তৈরি হওয়া কিছু প্যাটার্ন নির্ভর সিস্টেম। আর সাধারণভাবেই মানুষের জন্য এ ধরনের প্যাটার্ন চিহ্নিত করতে পারাটা বেশ কঠিন। তাছাড়া সেগুলোকে কোনো কোডিং ইউনিটের মাধ্যমে প্রকাশ করাও বেশ কষ্টসাধ্য। কিন্তু কম্পিউটারের জন্য প্যাটার্ন নিয়ে কাজ করাটা বর্তমানে বেশ সহজ পর্যায়ে চলে এসেছে।

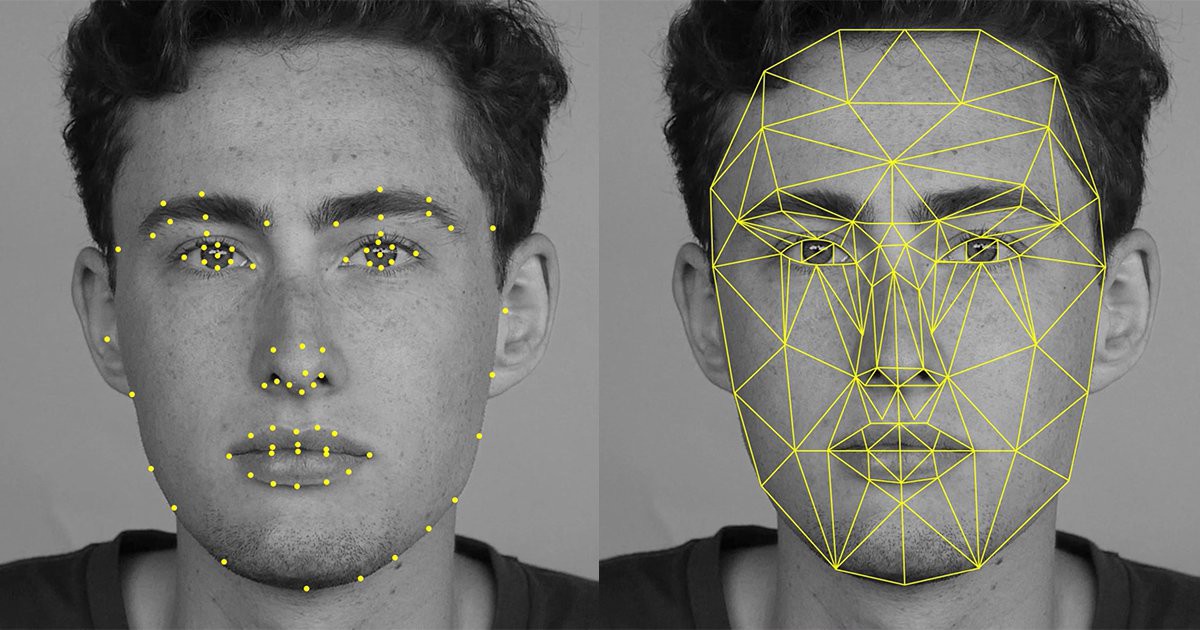

বিশেষ করে, ফেসিয়াল রিকগনিশন ইঞ্জিনগুলো ক্যামেরার মাধ্যমে পাওয়া ফটোগ্রাফ বা ভিডিও ফুটেজ থেকে মানুষের চেহারার নোডাল-পয়েন্টগুলোকে বিবেচনায় এনে চেহারার জ্যামিতিক প্যাটার্ন তৈরি করতে পারে এবং বলে দিতে পারে মানুষটির আসল পরিচয়।

মাংসপেশির সঙ্কোচন আর প্রসারণের ফলে নোডাল-পয়েন্টগুলোতেও পরিবর্তন আসে। অর্থাৎ, এখন চাইলেই নির্দিষ্ট অ্যালগরিদম ব্যবহার করে চেহারার যে সব অংশগুলোকে দেখে ইমোশন চিহ্নিত করা হয়, সেগুলোর জ্যামিতিক প্যাটার্ন সহজেই আলাদা করা যেতে পারে এবং সেগুলোকে অ্যালগরিদম মেনে ফেশিয়াল অ্যাকশন কোডিং সিস্টেমের আওতায় নেওয়া যায়। ডাটাসেটে থাকা পূর্ববর্তী মৌলিক ইমোশন ও মাইক্রো-ইমোশনগুলোর ইউনিট কোডের সাথে নির্দিষ্ট চেহারা থেকে পাওয়া কোডগুলোকে মিলিয়ে বেশ সহজেই ফটোতে থাকা ব্যক্তিটির ইমোশনাল স্টেট সনাক্ত করা যায়।

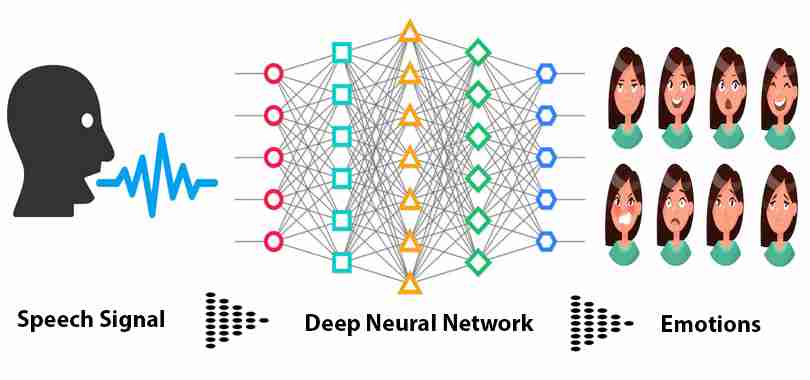

নার্ভাস সিস্টেমের যেকোনো পরিবর্তন কথা বলার সময় মানুষের কণ্ঠস্বরে প্রভাব ফেলতে পারে। যার ফলে কথা বলার সময় কণ্ঠস্বরের ওঠা-নামাসহ কথা বলা বেশ দ্রুত ও আস্তে হয়ে যায়। যার মাধ্যমে মানুষটি রেগে আছে, নাকি ভয় পাচ্ছে, বেশ আনন্দে আছে, নাকি দুঃখে আছে, তা সনাক্ত করা সম্ভব। মানুষের মতো মেশিনও স্পিচ রিকগনিশন, ন্যাচারাল ল্যাঙ্গুয়েজ প্রসেসিং ও ইমোশনাল স্পিচ প্রসেসিং টেকনোলজি ব্যবহার করে এ ধরনের ইমোশনাল স্টেট সনাক্ত করতে পারে।

অন্যদিকে, মেশিনের জন্য একটি নির্দিষ্ট ফটোগ্রাফ বা ইমেজ থেকে ইমোশনাল স্টেট সনাক্ত করা বেশ সহজ। কিন্তু, কোনো ক্যামেরায় বা ওয়েবক্যামে পাওয়া ভিডিও ফুটেজ থেকে তা সনাক্ত করা কঠিন। কেননা, সেখানে মানুষের চেহারার আবেগের উত্থান-পতন বেশ দ্রুত ঘটে। তাছাড়া যদি সাথে কণ্ঠের উঠা-নামাকেও বিবেচনায় আনা হয়, তাহলে তা আরো বেশি কঠিন হয়ে ওঠে।

এই সমস্যা সমাধানের জন্য মেশিন লার্নিং, ডিপ লার্নিং, নিউরাল নেটওয়ার্ক, ডিপ নিউরাল নেটওয়ার্কসহ আর্টিফিশিয়াল ইন্টেলিজেন্সের অন্যান্য শাখাগুলোর সাহায্য নেওয়া হয়। এছাড়াও মেশিন যে শুধু ইমোশন সনাক্ত করার মধ্যেই আটকে থাকে, তা নয়। বরং তাকে নতুন নতুন ক্ষুদ্র ইমোশনাল স্টেট সনাক্ত করে ডাটাসেট আপডেট করাসহ মানুষের ইমোশনাল স্টেটের উপর ভিত্তি করে প্রতিক্রিয়াও করতে হয়। সুপারভাইজড ও আনসুপারভাইজড লার্নিংয়ের সাহায্যে বর্তমানে সেগুলোও বেশ সহজ পর্যায়ে চলে এসেছে।

নানা খাতে ইমোশন এআই

বর্তমানে পৃথিবীব্যাপী অনেকগুলো ইমোশন এআই নির্ভর স্টার্টাপ গড়ে উঠেছে। এফেক্টিভা, বিয়োন্ড ভার্বাল, ইমোটিবট, তাওনাই, ক্রাউডইমোশন, ইমোশিয়েন্ট, পয়েন্টগ্রাবসহ আরো অনেকগুলো স্টার্টাপ ইমোশন এআই নির্ভর এপ্লিকেশন সুবিধা প্রদান করে থাকে। স্টার্টাপগুলো তাদের এপ্লিকেশনগুলোকে নানাভাবে ব্যবহার উপযোগী করে উপস্থাপন করলেও, প্রায় সবগুলোই একই ধরনের সমস্যা সমাধান করার জন্য কাজ করে যাচ্ছে।

গাড়ি দুর্ঘটনা রোধ

২০১৮ সালের হিসেব অনুযায়ী পৃথিবীব্যাপী বছরে প্রায় ১.২৫ মিলিয়ন মানুষ গাড়ি দুর্ঘটনায় মারা যায় এবং প্রায় ২০ থেকে ৫০ মিলিয়ন মানুষ হতাহতের শিকার হয়। গাড়ির অভ্যন্তরীণ কল-কবজা ঠিক মতো কাজ না করা, রাস্তা ঠিক না থাকা, প্রাকৃতিক দুর্যোগ ছাড়াও শুধুমাত্র ড্রাইবারের অসতর্কতার কারণে অধিকাংশ দুর্ঘটনাগুলো ঘটে। অধিকাংশ দুর্ঘটনার জন্য দায়ী গাড়ি চালানোর সময় চালকের কয়েক সেকেন্ডের অমনোযোগ। ঘটে যাওয়া কোনো খারাপ ঘটনা ভেবে তৈরি হওয়া অতিরিক্ত রাগ, দুঃখ, ড্রাইভিংয়ের সময় ফোনে কথা বলা, পাশে বা পেছনের আসনে বসা যাত্রীদের সাথে রাগ দেখিয়ে বা হাসি-ঠাট্টার ছলে কথা বলা, অন্যমনস্ক থাকা, তন্দ্রালু হওয়া, নেভিগেশন সিস্টেম বা ম্যাপে চোখ বোলানো এবং মাতাল হয়ে গাড়ি চালানো এই অমনোযোগের অন্যতম কারণ।

কম্পিউটার ভিশন টেকনোলজির সাথে ইমোশন এআই ব্যবহার করে অমনোযোগী ড্রাইভারকে সতর্ক করে দুর্ঘটনাগুলো রোধ করা সম্ভব। চালক যদি ফোনে কথা বলে বা রাস্তায় মনোযোগ না দিয়ে অন্য কোনো কাজে ব্যস্ত থাকে, তাহলে কম্পিউটার ভিশনের সাহায্যে তা সনাক্ত করে উপযুক্ত অ্যাপ্লিকেশনের সাহায্যে চালককে সতর্ক করা যায়। অন্যদিকে, ড্রাইভিং চলাকালে যদি চালকের মধ্যে অতিরিক্ত রাগ, দুঃখসহ সংবেদনশীল কোনো আবেগ প্রকাশ পায় বা চালকের মধ্যে যদি তন্দ্রাচ্ছন্ন ভাব দেখা দেয়, তাহলে ইমোশন এইআই’য়ের সাহায্যে তা সনাক্ত করে চালককে মনোযোগী হতে সতর্ক করবে।

এছাড়াও চালকের চেহারার মধ্যে যদি অতিরিক্ত কষ্টের ছাপ দেখা যায়, যাতে মনে হতে পারে তিনি স্ট্রোক করেছেন, বা তাকে বারবার সতর্ক করার পরেও যদি তার মধ্যে মনোযোগী হওয়ার ভাব না দেখা যায়, তাহলে স্বয়ংক্রিয়ভাবে গাড়ির ইঞ্জিন বন্ধ করাসহ কাছাকাছি থাকা কর্তৃপক্ষকে জানিয়েও দেওয়ার কাজটিও গাড়িতে থাকা এপ্লিকেশনটি করতে সক্ষম।

ফিডব্যাক সার্ভে

প্রত্যেকটি পণ্য বা সেবা গ্রাহকদের নির্দিষ্ট কোনো সমস্যাকে সমাধান করা বা তাদের কোনো প্রয়োজন মেটানোর জন্য তৈরি। দিনের পর দিন ঐ পণ্য বা সেবার মান উন্নত করার জন্য গ্রাহকদের কাছ থেকে যথাযথ ফিডব্যাক পাওয়াসহ কোনো পণ্য বা সেবাটি গ্রাহক গ্রহণ করছে, কোনটি করছে না, তা জানাটাও কোম্পানির জন্য গুরুত্বপূর্ণ। কেননা, যেখানে একটি নির্দিষ্ট পণ্য বা সেবার জন্য পর্যাপ্ত গ্রাহক নেই, সেখানে ঐ পণ্য বা সেবাটি রাখা মানে মূল্যবান অর্থের অপচয়।

কোম্পানিগুলো এই ফিডব্যাক নেওয়ার কাজটি করে থাকে ‘ফিডব্যাক সার্ভে’র মাধ্যমে। কিন্তু সব সময় গ্রাহকদের কাছে সঠিক প্রশ্নটি করে তাদের ফিডব্যাক নেওয়াটা সম্ভব নয়। গ্রাহকরাও গঠনমূলক ফিডব্যাক দিতে বাধ্য নয়। তাই কোম্পানিগুলো নানা কৌশল অবলম্বন করে থাকে। তবে এ ধরনের সমস্যাগুলোর সহজ এবং কার্যকরী সমাধানের জন্য ইমোশন এআই বেশ কাজে আসতে পারে।

উদাহরণস্বরুপ, কোনো একটি ব্র্যান্ডের কাপড়ের দোকানের কথাই চিন্তা করুন। নির্দিষ্ট একটি কাপড়ের উপর অধিকাংশ গ্রাহকদের প্রশংসার দৃষ্টি গেলেও প্রাইস ট্যাগ দেখে হয়তো তাদের চেহারায় অসন্তুষ্টি বা বিষণ্নতা ভর করে। ব্যাপারটি দোকানের কর্মচারীদের চোখে না পড়লেও সার্ভিলেন্স ক্যামেরায় সেটি ধরা পড়ে।

এখন ইমোশন এআই’য়ের মাধ্যমে ফুটেজগুলোকে বিশ্লেষণ করে কাপড়টি গ্রাহকদের চোখে পড়ার সময়ের অবস্থা আর প্রাইস ট্যাগ দেখার সময়ের অবস্থা বিবেচনায় এনে কাপড়টির স্বল্প বিক্রয় হওয়া বা না হওয়ার সম্ভাব্য কারণ হিসেবে কাপড়টির উচ্চমূল্যকে চিহ্নিত করা যাবে। সাথে বিগ ডাটা, মেশিন লার্নিংয়ের নানা এপ্লিকেশন ব্যবহার করে স্থানীয় লোকদের অর্থনৈতিক অবস্থা, ফ্যাশন সেন্স, দোকানের অন্যান্য পোশাকগুলোকে দেখে তাদের কীরকম অনুভূতি হয় এবং অন্যান্য তথ্য বিবেচনায় এনে মেশিন হয়তো ঐ নির্ধারিত কাপড়টির মূল্য ঐ এলাকায় কেমন হতে পারে, তা বলে দিতে পারবে।

ই-কমার্স, কন্টেন্ট পাবলিশিং সাইটগুলোর জন্যও ইমোশন এআই ব্যবহার করে ফিডব্যাক নেওয়ার কাজটি সহজ হয়ে যাবে। ইমোশন এআই সংযুক্ত ওয়েবসাইটগুলো ব্রাউজিংয়ের সময় নির্দিষ্ট কারণ দর্শীয়ে গ্রাহক বা পাঠকদের ফোনের ক্যামেরা বা পিসির ওয়েবক্যামের এক্সেস চাইবে। যদি তিনি ওয়েবসাইটটিকে এক্সেস প্রদান করেন, তাহলে এপ্লিকেশনটি কোনো পণ্য দেখা বা কোনো কন্টেন্ট পড়ার সময় তার চেহারায় কী ধরনের আবেগের উত্থান-পতন ঘটে তা চিহ্নিত করবে এবং সেগুলোকে বিশ্লেষণ করে, সে অনুযায়ী পরবর্তীতে পণ্য বা লেখা সুপারিশ করবে।

ভিডিও গেমিং

২০১৮ সালে প্রাপ্ত হিসেব অনুযায়ী বৈশ্বিক ভিডিও গেইম ইন্ডাস্ট্রি প্রায় ১৩৫ বিলিয়ন ডলার সমমূল্যের, যা বর্তমানে একশত পঞ্চাশ বিলিয়ন ডলার ছাড়িয়েছে। যার মধ্যে শীর্ষ পাঁচটি কোম্পানি ‘ওপেন ওয়ার্ল্ড গেম’ ইন্ডাস্ট্রি থেকে ২০১৫ সালের মধ্যেই আয় করেছে ৯৮ বিলিয়ন ডলার।

ওপেন ওয়ার্ল্ড গেম মূলত সেগুলোকেই বলা হয়, যেখানে গেমার স্বাধীনভাবে গেমের পটভূমিতে ঘুরে বেড়ানোর পাশাপাশি একই অবজেক্টিভ সম্পূর্ণ স্বাধীনভাবে সম্পূর্ণ করতে পারে। নন লিনিয়ার ধাঁচের এই গেমগুলোতে গেমাররা বাস্তব পৃথিবীর অভিজ্ঞতার মুখোমুখি হওয়ার সুযোগ পায়। ভবিষ্যতে ওপেন ওয়ার্ল্ড গেম ইন্ডাস্ট্রিগুলো ইমোশন এআই ব্যবহার করে গেমারদেরকে আরো বেশি বাস্তব অভিজ্ঞতার মুখোমুখি করতে সচেষ্ট হবে। যেখানে গেম কনসোলের সাথে যুক্ত থাকা ক্যামেরা গেমারের মুখের অভিব্যক্তি সনাক্ত করে সে অনুযায়ী পুরো গেমের পরিবেশে পরিবর্তন আনতে পারবে।

জালিয়াতি সনাক্তকরণ

এক গবেষণায় দেখা গেছে, প্রায় ৩০ শতাংশ গ্রাহক তাদের গাড়ির ইনস্যুরেন্স কোম্পানিগুলোর কাছে মিথ্যা বলে ইনস্যুরেন্স সুবিধা দাবী করে থাকে। ইনস্যুরেন্স কোম্পানিগুলো গ্রাহকের ভয়েজ অ্যানালাইসিসের মাধ্যমে কোনো গ্রাহকের দাবী সত্য, নাকি মিথ্যা তা সনাক্ত করতে পারবে। তাছাড়া আইন প্রয়োগকারী সংস্থাগুলোও অভিযুক্তদের জিজ্ঞাসাবাদের সময় ইমোশন এআই ব্যবহার করে সত্য-মিথ্যা যাচাই করতে পারবে।

কাউন্সেলিং

ইমোশন এআই’য়ের সাহায্যে ক্লাসের অমনোযোগী ছাত্রগুলোকে চিহ্নিত করা সম্ভব। শিক্ষার্থীদের চেহারার অভিব্যক্তি বিবেচনায় এনে ঠিক কী কারণে তারা অমনোযোগী তা সনাক্ত করে তাদেরকে সে অনুযায়ী কাউন্সেলিং করার কাজটি ভবিষ্যতে চোখে পড়বে।

তাছাড়া ইমোশন এআই সম্পৃক্ত এপ্লিকেশনের সাহায্যে ব্যক্তিগত স্মার্ট ফোনটি ব্যবহারকারীর মুডের উপর ভিত্তি করে পরামর্শ প্রদান করতে পারবে। এমনকি শুধুমাত্র ফোনে কথা বলার সময় গলার কণ্ঠস্বর বিশ্লেষণ করে ব্যবহারকারীর মুড কেমন আছে সনাক্ত করার পাশাপাশি কাউন্সেলিং করতে পারবে। উন্নত হাসপাতালগুলো ডিপ্রেশন ও ডিমেনশিয়ায় ভোগা রোগীদের অবস্থা ট্র্যাক করতে ইমোশন এআই’য়ের ব্যবহার শুরু করেছে।

উপরোক্ত খাতগুলো ছাড়াও পাবলিক সার্ভিস, কল সেন্টার, এমপ্লয়ি রিক্রুটসহ নানা খাতে ইমোশন এআই’য়ের ব্যবহার দিন দিন বেড়েই চলছে।

যে ঝুঁকিগুলো নিতে হতে পারে

ইমোশন এআই যে শুধুমাত্র ভালো কাজ, সমস্যা সমাধানেই ব্যবহার করা যাবে, তা নয়। বরং অন্যান্য যেকোনো প্রযুক্তির মতো এই প্রযুক্তিকেও বিভিন্ন খারাপ কাজ, সমস্যা তৈরিতেও ব্যবহার করা যাবে। বুদ্ধিমান মেশিন মানুষের উপর খবরদারি করার আশঙ্কার কথা পুরোপুরি বাদ দিলেও, খারাপ মানুষ বা কোম্পানিগুলো নিজেদের স্বার্থে এই প্রযুক্তিকে খুব সূক্ষ্মভাবে নিজেদের অন্যায় কাজে ব্যবহার করতে পারবে। বিশেষ করে কণ্ঠস্বর নকল করে মিথ্যা বলা, কারো আইডেন্টি চুরি, প্রোপাগান্ডা ছড়ানোসহ নানা কাজে এই প্রযুক্তি ব্যবহার হতে পারে।

টেক্সট টু স্পিচ জেনারেটর সফটওয়্যারগুলোর জন্য ন্যাচারাল সাউন্ডিং স্পিচ তৈরি করা বেশ কঠিন। অবশ্য অ্যালেক্সা, সিরি, গুগল অ্যাসিস্ট্যান্টের জন্য তাদের প্রতিষ্ঠানগুলো অনেকটা উপযুক্ত ইন্টারফেস তৈরি করতে পেরেছে। সেগুলো পূর্বে রেকর্ড করা একটি কণ্ঠস্বরের উপর নির্ভর করে টেক্সটগুলোকে স্পিচে রূপান্তর করে। যা সাধারণ টেক্সট টু স্পিচ জেনারেটর সফটওয়্যারগুলো থেকে বেশি আধুনিক। কিন্তু কণ্ঠগুলোতে আবেগ-অনুভূতির অনুপস্থিতিতে কারণে সেগুলোকে সাধারণ মেশিন জেনারেটর স্পিচ হিসেবেই মূল্যায়ন করা হয়। অর্থাৎ, চাইলেই এই ধরনের ডিভাইসগুলোতে ব্যবহৃত প্রোগ্রাম দিয়ে কারো কণ্ঠস্বর নকল করে ধোঁকা দেওয়া যাবে না।

কিন্তু অন্যদিকে কানাডিয়ান টেক কোম্পানি ‘লাইরেবার্ড’ দাবি করেছে, তাদের তৈরি সফটওয়্যার যেকোনো ব্যক্তির কথা বিশ্লেষণ করে সেটির ডিজিটাল প্রতিলিপি তৈরি করতে পারে। এরপর চাইলে ইচ্ছামতো বাক্য ইনপুট হিসেবে দিলে সফটওয়্যারটি যেখানে যে পরিমাণ আবেগের প্রয়োজন সেগুলোর যোগান দিয়ে পুরোপুরি সেই মানুষের কণ্ঠস্বর অনুকরণ করতে পারে। কোম্পানিটি প্রমাণস্বরূপ আমেরিকার সাবেক প্রেসিডেন্ট বারাক ওবামার একটি ফেইক ভিডিও বার্তাও প্রকাশ করেন।

অন্যান্য যেকোনো সফটওয়্যারের মতো এই ধরনের সফটওয়্যারগুলো ভবিষ্যতে আরো উন্নত হওয়ার পাশাপাশি সহজলভ্য হবে। যে কেউ চাইলেই এগুলোকে ব্যবহার করে অসৎ উদ্দেশ্য হাসিল করতে পারবে। তাছাড়া ডাটা ব্রোকারদের কাছে যদি মানুষের অন্যান্য তথ্যের পাশাপাশি তাদের আবেগ-অনুভূতিগুলোর তথ্যও থাকে, তাহলে সেগুলোকে কাজে লাগিয়েও খারাপ উদ্দেশ্য চরিতার্থ করা সম্ভব।

ভবিষ্যৎ

২০২২ সালের মধ্যে আপনার ব্যক্তিগত ডিভাইসটি আপনার মানসিক অবস্থা, অনুভূতির ব্যাপারে আপনার পরিবারের চাইতেও বেশি জানবে।

২০১৮ সালের জানুয়ারি মাসে গার্টনার ইনকর্পোরেশনের গবেষক এনিটি জিমারম্যান এক বিবৃতিতে এই ভবিষ্যদ্বাণীটি করেছিলেন। এর মাত্র দুই মাস পর ইউনিভার্সিটি অফ ওহিও’র একদল গবেষক দাবী করেন, তাদের তৈরি অ্যালগরিদম অনুভূতি সনাক্তকরণে মানুষের চাইতেও বেশি এগিয়ে। মৌলিক আবেগগুলোর পাশাপাশি একইসাথে ঘটা ইমোশনগুলো; যেমন: বিস্ময়ের সাথে আনন্দিত হওয়া, বিস্ময়ের সাথে ভয় পাওয়া, বিষণ্ণতা, অমনোযোগী হওয়া, একইসাথে দুঃখী হওয়া ও রেগে থাকার মতো ইমোশনগুলো তারা সনাক্ত করতে সচেষ্ট হয়েছে।

অর্থাৎ, ইমোশন এআই’য়ের কল্যাণে দিন দিন মেশিনগুলো অনুভূতি সনাক্তকরণে মানুষের চাইতে বেশি শক্তিশালী ও দক্ষ হয়ে উঠছে। হবেই বা না কেন? যেখানে একজন মানুষ অন্য একজন মানুষকে বুঝতে, তার চেহারার অভিব্যক্তি সনাক্ত করতে অল্প কিছু সময় পায়, মেশিন সেখানে ঘণ্টার পর ঘণ্টা সেগুলো নিয়ে কাজ করতে পারে। নানা দেশের, নানান চেহারার লোকজনদের আলাদা আলাদা ডাটাসেটের সাহায্যে চিহ্নিত করতে পারে। দিনের পর দিন সেগুলোকে নানা রকমের অ্যালগরিদমের আওতায় এনে গবেষণা করতে পারে। আর এছাড়াও নানা রকমের সেন্সর মেশিনকে মানুষের মতো ঠান্ডা, গরমসহ আরো অন্যান্য অনুভূতির সাথে পরিচয় করিয়ে দিয়েছে, যা একসময় শুধু মানুষই অনুভব করতে পারতো।

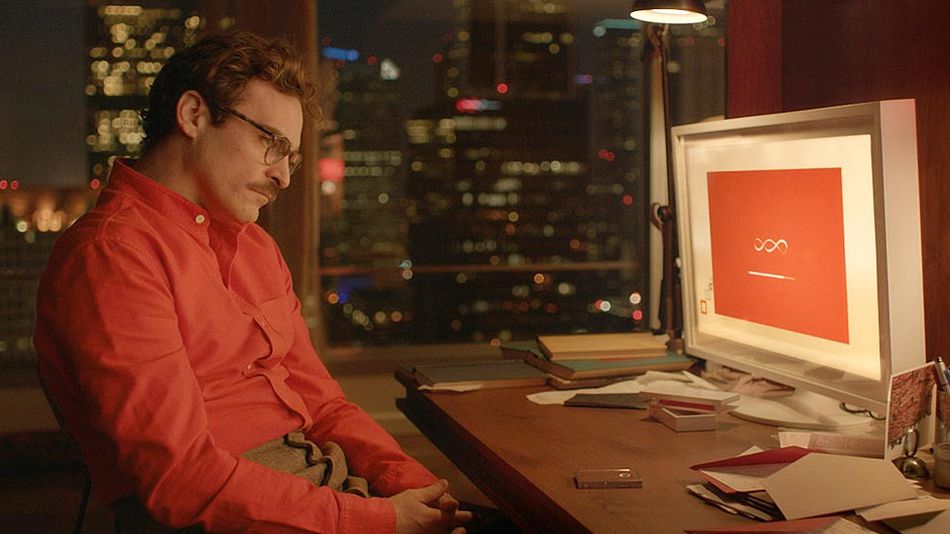

অতীতের টিভি সিরিজ বা মুভিগুলোতে রোবটকে দেখা যেত বেশ শুদ্ধ ইংরেজি বললেও, কথা বলার ধরন ছিল একঘেয়ে, অনুভূতিহীন। গত অর্ধ দশকে এই জায়গায় বেশ পরিবর্তন এসেছে। ২০১৩ সালে মুক্তি পাওয়া ‘HER’ মুভিটিতে দেখা যায় মূল চরিত্র থিওডর নিঃসঙ্গ জীবনে একটি কৃত্রিম বুদ্ধিমত্তাভিত্তিক অপারেটিং সিস্টেমের আগমন ঘটে। অপারেটিং সিস্টেমটি ইন্সটল করার সময় তিনি স্ত্রী কণ্ঠের একটি প্রোগ্রাম সেটআপ করেন এবং নাম দেন ‘সামান্থা’। প্রোগ্রামটির নিজস্ব চেতনা রয়েছে, বুদ্ধিমত্তা রয়েছে, রাগ-অভিমান করার পাশাপাশি অবস্থা বুঝে নিজেকে পরিবর্তন করার ক্ষমতাও রয়েছে। অর্থাৎ, প্রোগ্রামটিকে ফোনের অপরপাশে অবস্থিত জলজ্ব্যান্ত মানুষ বলেই মনে হয়। যার কারণে একসময় থিওডর সামান্থা নামের এআই বেসড প্রোগ্রামটির প্রেমে পড়ে যায়।

ইমোশন এআই’য়ের কল্যাণে ভবিষ্যতে মেশিনগুলোর মধ্যেও এই গুণগুলো দেখা যাবে। তবে প্রশ্ন থেকে যায়, ভবিষ্যতে মেশিন কি তাহলে অনুভূতিশীল হয়ে উঠবে? আর্টিফিশিয়াল ইন্টেলিজেন্সের ফাউন্ডিং ফাদার ‘মারভিন মিনস্ক্যাই’ এর উত্তর বহু আগে দিয়ে গিয়েছেন। তিনি বলেছিলেন, “বুদ্ধিমান মেশিন অনুভূতিশীল হবে কি, না; প্রশ্নটি তা নয়। প্রশ্নটি হচ্ছে, অনুভূতি ছাড়া মেশিন কি বুদ্ধিমান হতে পারবে?”

অনুভূতি ছাড়া শত শত শক্তিশালী প্রজাতিগুলোর মধ্যে মানুষের টিকে থাকা সম্ভব হতো না। এমনকি মানুষের বুদ্ধিমত্তা বিকাশের মূলেও রয়েছে তাদের অনুভূতি। অর্থাৎ, মেশিনকে আসল অর্থে বুদ্ধিমান হতে হলে অবশ্যই অনুভূতিশীল হতে হবে। আর ভবিষ্যতে মেশিন যদি মানুষের অনুভূতি অনুকরণ করতে পারে তাহলে মেশিনের সাথে মানুষের যোগাযোগ আরো বেশি যথাযথ হয়ে উঠবে। ব্যাপারটি বেশ কল্পনাপ্রবণ মনে হলেও অদূর ভবিষ্যতে এসবের বাস্তবে রূপ নেওয়ার সম্ভাবনা যে রয়েছে, তা ইমোশন এআই নির্ভর প্রযুক্তিগুলোর দ্রুত উন্নয়নই প্রমাণ করে।

অন্যদিকে ইউভাল নোয়াহ হারারি তার বই হোমো ডিউস: অ্যা ব্রিফ হিস্টোরি অফ টুমরো’তে বলেছেন, “মানুষ হচ্ছে মূলত অনেকগুলো জৈবিক অ্যালগরিদমের সংকলন, যা মিলিয়ন মিলিয়ন বছর ধরে বিবর্তিত হয়েছে।” অর্থাৎ, কোনোভাবে যদি আমরা আমাদের জৈবিক অ্যালগরিদমগুলোকে সনাক্ত করে মেশিনকে প্রদান করতে পারি, তাহলে মেশিন সেগুলোকে অনুকরণ করে মানুষের চাইতে আরো দ্রুত বিবর্তিত হতে পারবে। আরো অনুভূতিশীল, আরো বুদ্ধিমান হয়ে উঠতে পারবে।