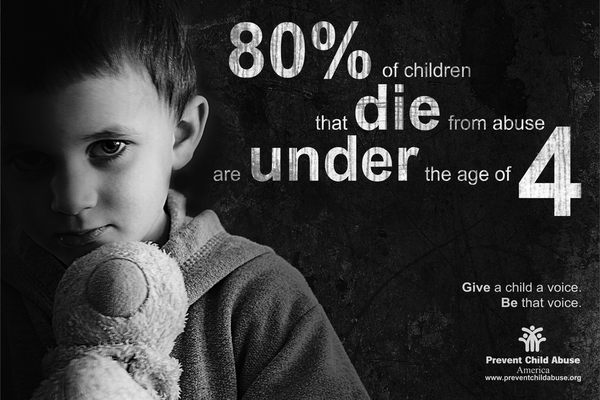

পত্রিকা খুললেই প্রতিদিন আমাদের কমপক্ষে একটি খবরের দেখা মিলবেই, তা হলো শিশু নির্যাতন। শিশু রাজন হত্যা আমাদের হৃদয় কাঁপিয়ে তুললেও গৃহপরিচারিকা রোকসানার মতো বর্তমানে প্রতিনিয়ত শিশু নির্যাতন এবং শিশু ধর্ষণের খবর আমাদের কাছে রোজকার খুব সাধারণ বিষয় হয়ে দাঁড়িয়েছে। পরিসংখ্যানই প্রমাণ করে দেয় শিশুদের প্রতি নির্মমতা এবং কঠোরতা কতটা ভয়াবহ পর্যায়ে পৌঁছেছে।

কেবলমাত্র বাংলাদেশেই ২০১৭ সালে ৩,৮৪৫ জন শিশু বিভিন্ন ধরনের নির্যাতন এবং সহিংসতার শিকার হয়েছে, বাস্তবে সংখ্যাটা আরো বেশি। আর সংখ্যার পরিমাণটা যেন প্রতি বছরেই নতুন রেকর্ড করে চলেছে।

শুধু বাংলাদেশ নয়, সারা বিশ্বের জন্য শিশু নির্যাতনের ভয়াবহতা এখন তীব্র মাথাব্যথার কারণ হয়ে দাঁড়িয়েছে। চারিদিকে এখন বিজ্ঞান-প্রযুক্তি এবং কৃত্রিম বুদ্ধিমত্তার জয়জয়কার। আর এই শিশু নির্যাতন ঠেকাতে তাই প্রযুক্তির আশ্রয় নেয়াটা আশ্চর্যজনক কিছু নয়।

তবে বাংলাদেশে এই ধরনের কোনো পদক্ষেপ না নেয়া হলেও ইংল্যান্ডের বেশ কিছু পরিষদ এই অপরাধ ঠেকাতে এবং নির্যাতিত শিশুদের চিহ্নিত করতে পদক্ষেপ গ্রহণ করছে।

কিছুদিন আগেও যেসব বিষয় শোভা পেত কল্পবিজ্ঞানের পাতায়, কৃত্রিম বুদ্ধিমত্তা (AI) এবং বিগ ডাটার আশীর্বাদে তা এখন আমাদের নিত্যদিনের সঙ্গী। আর এই বিগ ডাটা বা বিপুল সংখ্যক তথ্যকে ব্যবহার করে এবং প্রতিনিয়ত তথ্য সংগ্রহের মাধ্যমে তারা তৈরি করেছেন কম্পিউটার অ্যালগরিদম, যার মাধ্যমে কৃত্রিম বুদ্ধিমত্তা চিহ্নিত করতে পারবে নির্যাতিত শিশুদের। অর্থাৎ মানুষের উপর নির্ভরশীলতা অনেকাংশে কমিয়ে দিয়ে নির্যাতিত শিশুদের নিজে থেকেই শনাক্ত করবে এই তথ্য বিশ্লেষণী সিস্টেমটি।

একটি যন্ত্রের ভুল করার সম্ভাবনা মানুষের তুলনায় অনেক কম এ আমাদের সকলেরই জানা। কিন্তু বিষয়টি যখন শিশুদের বিপদ নিয়ে তখন প্রশ্ন উঠতেই পারে কতটুকু নিরাপদ এই প্রক্রিয়া? এখানে কেউ বৈষম্যতার শিকার হবে না তো? কীভাবেই বা কাজ করবে এই অ্যালগরিদম সিস্টেম? আর কাজটা যখন শিশুদের বিপুল পরিমাণ তথ্য নিয়ে, তখন তথ্য নিরাপত্তার বিষয়টি কী ঝুঁকির মুখে থাকছে না?

ইংল্যান্ড স্থানীয় সরকারের প্রায় পাঁচটি কর্তৃপক্ষ এ ব্যাপারে কাজ করছে যার মধ্যে অন্যতম হলো থারক (Thurrock) এবং হ্যাকনি (Hackney) কাউন্সিল। প্রায় ৩ লক্ষ ৭৭ হাজার মানুষের তথ্য তারা সংগ্রহ করেছেন এই সিস্টেমটি পরিচালনার জন্য। সাধারণত বিগ ডাটা ভিত্তিক প্রক্রিয়াগুলোতে প্রচুর পরিমাণের তথ্য নিয়ে কাজ করা হয়, আর তথ্যের পরিমাণ যত বেশি হবে সিস্টেম ঠিক ততটাই নির্ভুল ফলাফল দিতে সক্ষম হবে। বিগ ডাটার প্রতি আগ্রহী হয়ে ওঠার আরো একটি কারণ হলো যথেষ্ট পরিমাণ তহবিলের অভাব।

ইংল্যান্ডের এমনই আরেকটি পরিষদ হলো ব্রিস্টল কাউন্সিল, যেখানে শিশু নির্যাতন অ্যালগরিদম নিয়ে চলছে বিস্তর গবেষণা। তবে এই গবেষণার সাথে সাথে তাদের মুখোমুখি হতে হচ্ছে নীতিনৈতিকতা বিষয়ক বিভিন্ন প্রশ্নের। কাউন্সিলটিতে এই প্রক্রিয়ার তত্ত্বাবধানে থাকা গ্যারি ডেভিস অসুবিধার থেকে সুবিধার দিকটিতে বেশি নজর দিচ্ছেন। তার ভাষ্যমতে, এই প্রক্রিয়ার মাধ্যমে মানুষকে সিদ্ধান্ত নেয়ার দায়িত্ব থেকে পুরোপুরিভাবে সরিয়ে দেয়া হচ্ছে না, বরং মানুষ ভুল করে বসলে তা শুধরে দিবে এই অ্যালগরিদম। তিনি বলেন,

“এই অ্যালগরিদম আপনাকে নিশ্চিতভাবে বলে দিবে না যে শিশুটি শারীরিক বা মানসিকভাবে নির্যাতিত হবে কিংবা হারিয়ে যাবে, বরং এটি তার নির্যাতিত হবার আচরণগত বৈশিষ্ট্যগুলোকে প্রদর্শন করবে। শিশুটির দুর্বলতা আর তার ঝুঁকির বিষয়গুলোকে চিহ্নিত করবে।”

এই মডেলটির পরিকল্পনাকারীরা প্রথমেই কিছু ফলাফল সেট সংগ্রহ করবেন, এর দ্বারা সিস্টেমটি পরবর্তীতে কোনো শিশুর ব্যবহারিক আচরণ পর্যবেক্ষণ করে উভয়ের তুলনার মাধ্যমে একটি সিদ্ধান্ত গ্রহণ করবে।

যেমন- একটি শিশুকে যদি সিস্টেমটি পর্যবেক্ষণ করে তার আচরণ লক্ষ্য করে এবং মানসিক অবস্থার বহিঃপ্রকাশগুলোকে চিহ্নিত করতে পারে তবে তার ব্যাপারে বেশ কিছু তথ্য পাওয়া যাবে। এবার সিস্টেম অ্যালগরিদম অনুযায়ী পূর্বে সংগৃহীত অসংখ্য পরিমাণ ডাটাসেটের সাথে মিল খোঁজার চেষ্টা করবে। এভাবে একটি সিদ্ধান্তে পোঁছাতে পারবে এই সিস্টেমটি। এক্ষেত্রে কাউন্সিলগুলো পারিবারিক নির্যাতিত শিশু, কিশোর-কিশোরী নিপীড়ন, বিদ্যালয়চ্যূত কিশোর-কিশোরীদের ব্যাপারে তথ্য সংগ্রহ করছে। তবে পরিষ্কারভাবে কেউই জানায়নি তারা কী কী ধরনের তথ্য ব্যবহার করছেন। আর তাদের সিস্টেমটিই বা কীভাবে কাজ করছে।

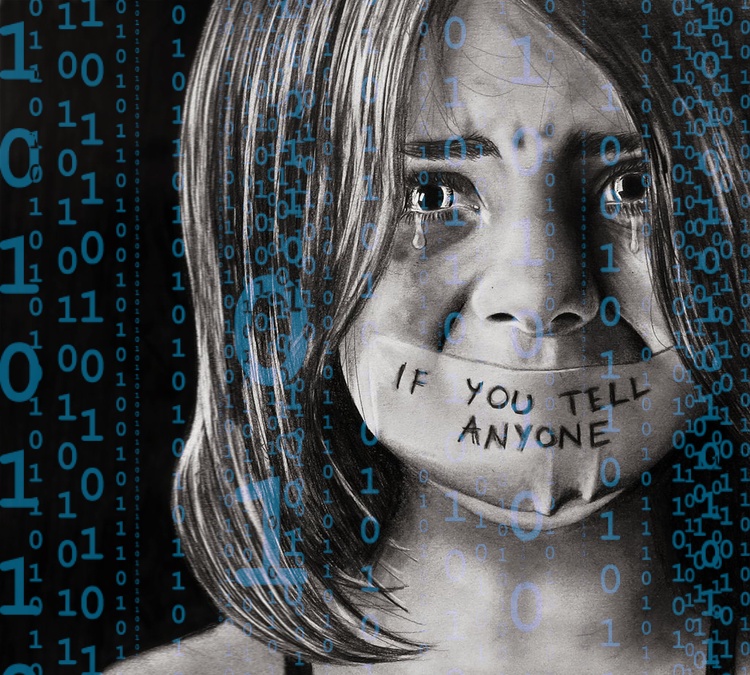

কিন্তু এই ধরনের একটি সিস্টেম নিঃসন্দেহে তথ্যগত নিরাপত্তা নিয়ে প্রশ্ন তুলছে।

থারক এবং হ্যাকনি কাউন্সিলকে বিশ্লেষণী সিস্টেমটির সেবা প্রদানকারী প্রতিষ্ঠান জান্তুরা (Xantura)-র প্রধান নির্বাহী ওয়াজিদ শাফিক জানান, তথ্য নিরাপত্তা এবং প্রযুক্তির ব্যবহার এই দুইয়ের মাঝে ভারসাম্য বজায় রাখা উচিত। তিনি বলেন,

“বিষয়টি আমার কাছে মনে হয়, আমরা কী পারবো এরকম কোনো সিস্টেম তৈরি করতে যা একইসাথে নির্যাতিতদের নিরাপত্তা দেবে এবং সবার অধিকার নিরাপত্তা নিশ্চিত করবে? অবশ্যই আমাদের তা পারতে হবে, নাহলে আমরা নির্যাতিতদের কোনো সাহায্য করতে পারবো না।”

কিন্তু সিস্টেমটির মূল ভিত্তি নিয়ে নানা রকম জটিল প্রশ্ন তৈরি করছে। মজার বিষয় হলো, কাউন্সিলগুলোর স্পষ্টভাবে ডাটা প্রক্রিয়ার কোনো অনুমতির দরকার নেই। চিল্ড্রেন অ্যাক্টের আইনানুযায়ী, তারা শিশুদের কল্যাণের কথা বলে অন্যের ব্যক্তিগত তথ্য প্রক্রিয়া করে যেতে পারবেন খুব সহজেই। কিন্তু এরপরেও তারা পুরোপুরিভাবে তথ্য নিরাপত্তার বিষয়টি ঢাকা দিতে পারবেন না। ইউনিভার্সিটি কলেজ লন্ডনের মেশিন লার্নিং গবেষক মাইকেল ভিয়েল জানান,

“আইনের জোরে তারা যেকোনো ধরনের তথ্য প্রদান অনুরোধ নাকচ করে দিতে পারলেও তাদের জটিল সিস্টেমটি কীভাবে কাজ করছে এই ব্যাপারে সাধারণ রূপে নির্দিষ্ট কিছু তথ্য দেয়া লাগবেই।”

জাতীয়ভাবে এই ধরনের সিস্টেমের তদারকির জন্য কোনো সংস্থা নেই। তাই একেক কর্তৃপক্ষ এর স্বচ্ছতা নিয়ে একেক রকম ধারণা দেবে- এটাই স্বাভাবিক। থারক কাউন্সিল এর নিরাপত্তা নিয়ে একটি নোটিশ তাদের ওয়েবসাইটে পাবলিশ করলেও সেখানে তারা পরিষ্কারভাবে কিছু উল্লেখ করেনি, এমনকি সচেতনতা তৈরির ব্যাপারেও কিছু উল্লেখ করা হয়নি। অপরদিকে হ্যাকনি কাউন্সিল বছরের শুরুর দিকে তথ্য স্বাধীনতা বিষয়ক একটি অনুরোধ নাকচ করে দিয়ে বলে,

“গবেষণায় কী ধরনের তথ্য ব্যবহার করা হচ্ছে তা জানানো হবে না। কারণ তা জানানো হলে এই সিস্টেমটি যে কারণে তৈরি করা হয়েছে তাতে অন্যের হস্তক্ষেপ বৃদ্ধি পাবে।”

ওয়াজিদ শাফিক জানান, তার কোম্পানি কেবলমাত্র অনুমোদিত এবং সংবিধিবদ্ধ আইনের আওতায় তথ্য নিয়ে কাজ করে যাচ্ছে। আর যেহেতু বিষয়টি জনসম্মুখে এসেছে, তাই এখানে ক্যামব্রিজ অ্যানালিটিকার মতো ঘটনা ঘটবে না। তবে তিনি এটাও জানান, এর জন্য কর্তৃপক্ষকে আরো সচেতন হতে হবে। জনগণকে জানাতে হবে আমরা কী করছি এবং কেন করছি। “জনগণের সাথে আমাদের আরো খোলামেলা আলোচনায় বসা উচিত যাতে পুরো বিষয়টি আরো উপযুক্ত এবং সামঞ্জস্যপূর্ণ হয়।”

কিন্তু এই সিস্টেমের বিরুদ্ধে আরো একটি অভিযোগ হলো সুবিধাবঞ্চিত একটি শ্রেণীর উপর বেশি নজর দেয়া। এর ফলে একপাক্ষিকতা প্রকাশ পাচ্ছে। অনেকেই ধারণা করছেন, কাউন্সিলগুলো যতটা না গরীব পরিবারগুলোর উপর নজরদারী করবে, ততটা ধনী পরিবারগুলোর উপর করবে না। অটোমেটিং ইনইক্যুয়ালিটি বইয়ের লেখক ভার্জিনিয়া জানান,

“যদি সিস্টেমের মধ্যে কোনো ত্রুটি থাকে বা কোনো একটি শ্রেণীর ডাটা বেশি সংগ্রহ করা হয় তবে আপনি কেবল অসাম্যতার প্রতিফলনই ঘটাচ্ছেন না, সাথে সাথে এটিকে অসামঞ্জস্য করে তুলছেন একটি ত্রুটিপূর্ণ ফলাফল প্রদর্শনের মাধ্যমে।”

ভিয়েল এক্ষেত্রে প্রাইভেট এবং পাবলিক বিদ্যালয়গুলোর উদাহরণ সামনে আনেন। পাবলিক বিদ্যালয়গুলোতে মডেল অনুসারে হয়তো শিশুরা ‘ঝুঁকির’ একটি পর্যায় পার করে না, তারা নিরাপদ হিসেবে চিহ্নিত হচ্ছে। কিন্তু তার মানে এই না যে প্রাইভেট বিদ্যালয়গুলোতেও ঝুঁকির মাত্রাটা একই থাকবে। বরং সেখানে আরো বেশি হবে। তাই একটি ক্ষেত্রের ফলাফল দিয়ে আরেকটি ক্ষেত্র নিয়ে ধারণা করে মডেল সঠিক ফলাফল দেবে না।

আর্টিফিশিয়াল ইন্টেলিজেন্স এবং বিগ ডাটা নিঃসন্দেহে অপরাধ বা বিপদ ঘটানো রোধের একটি উপযুক্ত হাতিয়ার। আমরা ইতোমধ্যে জীবনের অনেক ক্ষেত্রেই অনেক কাজই এই যন্ত্রগুলোর উপর ছেড়ে দিয়েছি। কিন্তু এই সিস্টেম কি এখনো পুরোপুরিভাবে তৈরি এই বাস্তবতা মোকাবিলা করতে? থারক এবং হ্যাকনি কাউন্সিলের সফটওয়্যারের নির্ভুলতার পরিমাণ এখন পর্যন্ত শতকরা ৮০ ভাগ। এতদিন আমরা এই ধরনের ঘটনা কেবল সাই-ফাই মুভি কিংবা বইয়ের পাতাতেই দেখতাম, কিন্তু এখন তা পৌঁছে গেছে বাস্তব জগতে।

তবুও এই সিস্টেম মানুষেরই তৈরি, যাতে তারা নিজেদের ভুলগুলো শুধরানোর দায়িত্ব মেশিনের উপর ছেড়ে দিতে পারে। কিন্তু এর বিরুদ্ধে অভিযোগ এনেছে অনেকেই।

প্রতিবাদ করেছেন অনেকে। তদের মতে, কখনোই একটি যন্ত্র এত সংবেদনশীল বিষয়ে ভূমিকা রাখতে পারে না। এছাড়াও অনুমতি ছাড়া তাদের তথ্য সংগ্রহ করা হচ্ছে তাদের অগোচরে, যা তাদের গোপনীয়তা লঙ্ঘন করছে।

আপনার কী মনে হয়? এই সিস্টেম কতটুকু নির্ভরযোগ্য? এখানে কী কোনো ধরনের পরিবর্তন আনা যেতে পারে? নিজ দেশেই বা এর সম্ভাবনা কতটুকু? আপনি সিস্টেমটিকে নিজের মতো করে কীভাবে দেখেন? আমাদের জানাতে ভুলবেন না আপনার মতামত।